FOCUS: Il futuro dell'animazione è in tempo reale

23 Maggio 2016

Leggi...

Lo scorso 15 Maggio 2016 la Fox ha trasmesso un nuovo episodio de I Simpson, episodio con un finale un po particolare perchè "in diretta". Niente di strano se si pensa che il prodotto di cui parliamo è completamente animato, ovvero generalmente realizzato mesi prima e con il lavoro di centinaia di disegnatori e animatori e non con attori in carne ed ossa davanti alla telecamera.

Ma allora cos'è andato in onda e come hanno fattoi suoi autori a realizzarlo? Per rispondere alla prima domanda trovate di seguito il video che mostra Homer Simpson (con la voce originale del suo doppiatore Dan Castellaneta) rispondere in tempo reale ad alcuni fans che si sono prenotati al telefono da un lato all'altro degli States, mentre subito dopo invece cerchiamo di far luce sulla seconda domanda.

Il lavoro.

Già diverse settimane prima della messa in onda di questo episodio, subito dopo l'annuncio di questo evento, molti avevano ipotizzato a sistemi di motion capture o marionette o qualunque altro sistema, senza sapere che dietro tutto si nascondeva invece un nuovo software messo appunto dagli ingegneri Adobe.

Tutt'ora in sviluppo, si chiama Adobe Character Animator e ha due particolarità su tutte: la sincronizzazione labiale e la cattura dei movimenti, entrambi in tempo reale.

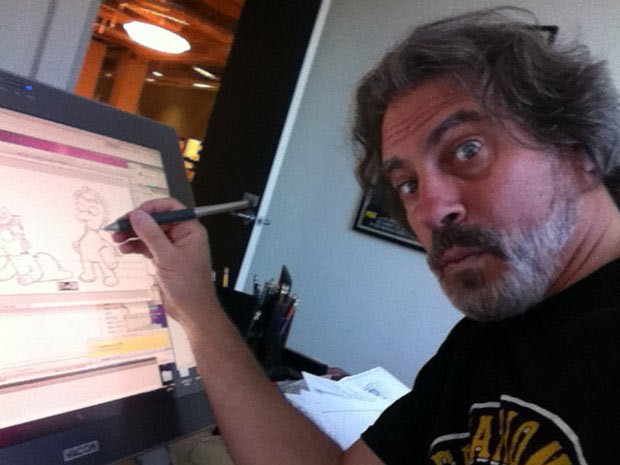

Grazie ad uno dei registi della serie I Simpson David Silverman e del co-fondatore di After Effect oggi al lavoro su Character Animator David Simon, facciamo luce sul programma e su tutto il processo.

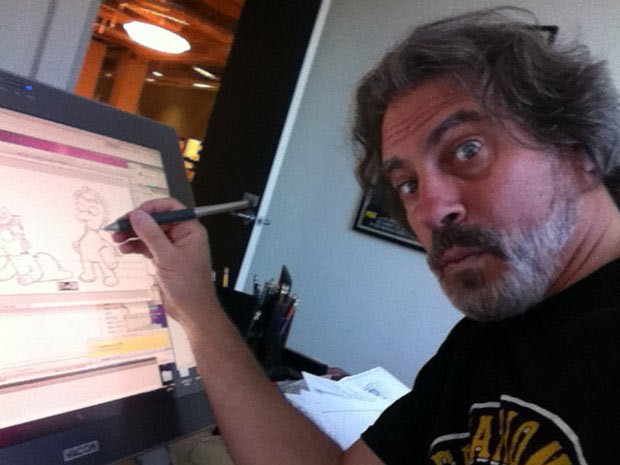

Il regista Silverman (in foto quì sopra) racconta che l'idea di "animazioni in tempo reale" era già nell'aria da qualche anno. Poi il team de I Simpson ha notato il lavoro della divisione grafica del canale Fox Sports sulla mascotte robot Cleatus che interviene in tempo reale durante gli incontri. Da quì si è arrivati ad una nuova feature di After Effect, una versione preliminare di Character Animator, programma in grado di gestire e animare gli "strati" (layer) 2D di Abobe Illustrator (grafica vettoriale) o Photoshop (grafica raster o bitmap) - quest'ultimo scelto per questo segmento/esperimento de I Simpson.

Per fare un esempio: per far parlare un personaggio 2D è necessario realizzare tanti disegni della bocca quante le esplessioni dei fonemi o principalmente quelle delle vocali (visto che molti fonemi hanno espressioni in comune). Questi disegni sovrapposti uno dietro l'altro, formano parole e intere frasi. La programmazione di questi disegni di solito è fatta secondo i copioni precedentemente scritti e l'intero processo non è certamente da intendersi in tempo reale, anzi, ogni secondo di animazione prevede fino a 24 immagini differenti con conseguenti tempi di produzione molto lunghi.

In questa fase può interviene questo nuovo software.

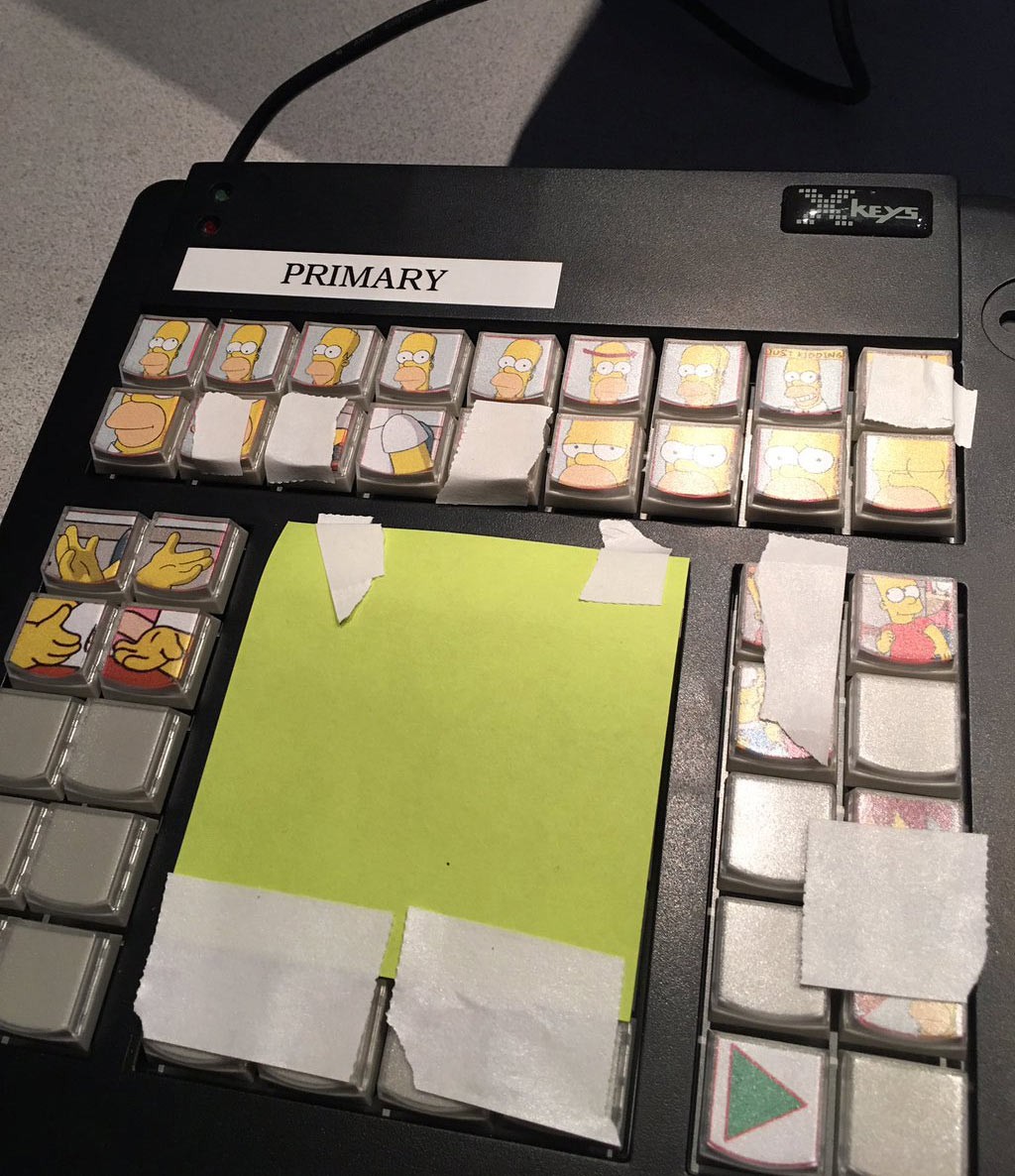

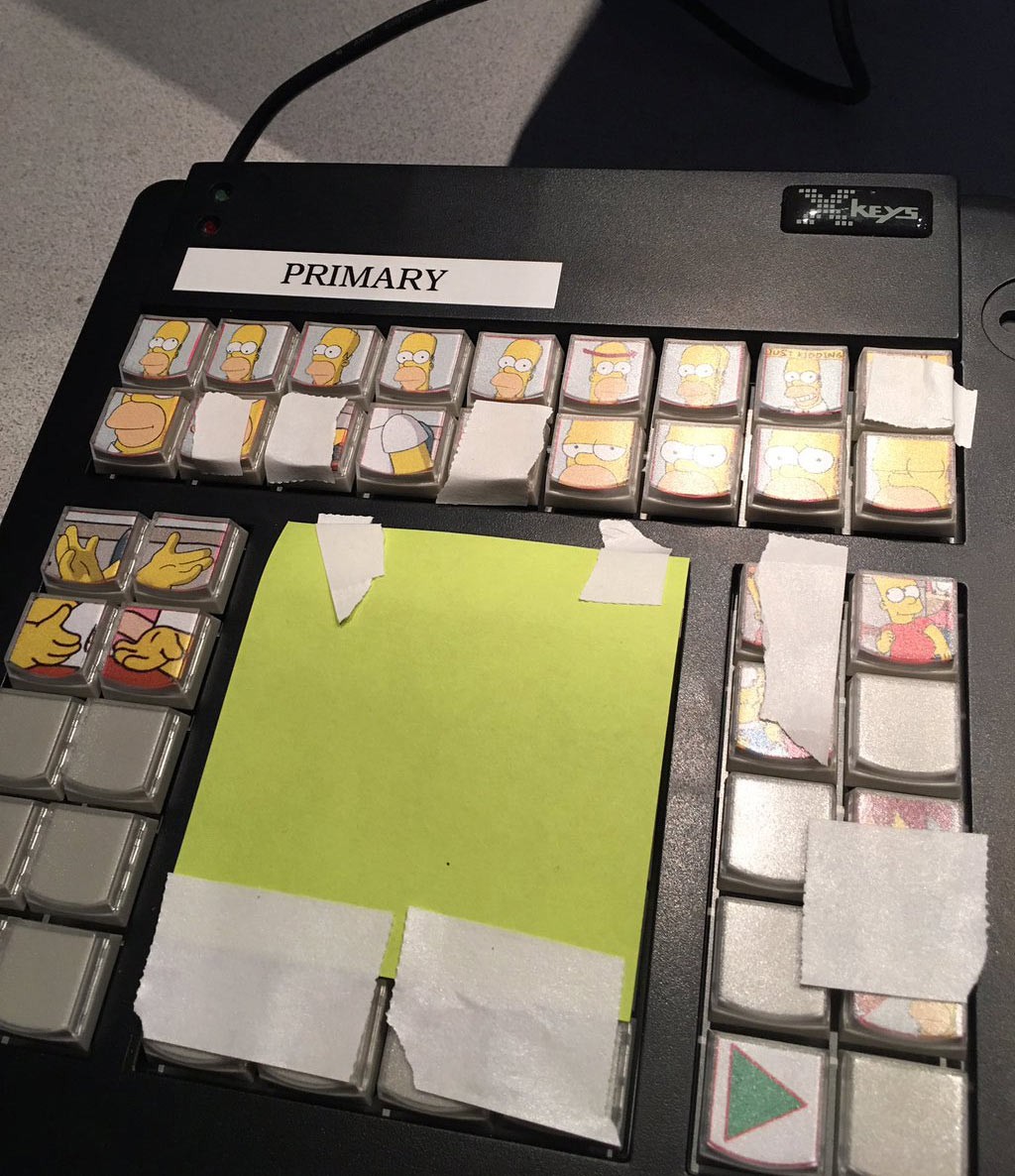

Si parte impostando per prima la scena completa con lo sfondo e tutti i personaggi e gli elementi in movimento e non, e definendo poi quali elementi devono interagire con il programma d'animazione (esempio: quale disegno corrisponde alla lettea "A", quale alla "E" ect.). All'inizio, nelle prime versione del software, il lavoro era tutto effettuato tramite la pressione dei tasti di una tastiera, sempre in tempo reale, (dunque con una tastiera o un keypad con pre-impostati azioni/movimenti per ogni tasto) ma solo ultimamente si è arrivato al livello successivo, il vero salto di qualità, che comprende la sincronizzazione labiale tramite l'audio di un microfono e le espressioni facciali e i movimenti tramite la cattura del video di una videocamera.

Ricordando che il software è tutt'ora in fase di sviluppo, per l'episodio live de I Simpson non è stata utilizzata la cattura dei movimenti in tempo reale ma solo la sincronizzazione labiale con la voce di Dan Castellaneta e una tastiera (il keypad in foto quì sopra) operata dal regista in persona in cui erano state impostate delle animazioni collaterali (altri prersonaggi non parlanti che entravano in scena) o piccoli movimenti gestuali di Homer, così da poter offrire la stessa qualità dei disegni della serie originale. Molte altre animazioni, ammette il regista, erano state preparate ma non sono poi state usate, pronte solo "in caso di", mentre il risultato finale, continua Silverman, è stato comunque accettabile e ha dato solo qualche piccolissimo problema con le interazioni reali, perchè selezionate tramite tastiera da una persona diversa dal doppiatore che parlava, con al massimo mezzo secondo di ritardo.

Un lavoro di preparazione molto particolare e lungo e una sessione live che il regista stesso ha ammesso di non aver patito grazie alla sua esperienza di musicista, che gli ha insegnato come improvvisare o correggersi in tempo reale sul palco durante un esibizione.

Meglio di tante parole, vi mostriamo di seguito in pochi minuti il potenziale di questo programma:

Il futuro.

Di software in grado di gestire animazioni in tempo reale, principalmente in computer grafica, applicati spesso ai giochi, ce ne sono già sul mercato e Charater Animator non farà altro che apportare nuova carne al fuoco nel mercato delle produzioni animate anche di alto livello, permettendo di abbassare drasticamente i budget, offrire nuovi strumenti per realizzare espressioni facciali e movimenti sempre più precise e lasciare magari concentrare gli autori su altri aspetti importanti della produzione.

Certamente come quest'esperimento con il segmento live de I Simpson conferma, la qualità della sincronizzazione non è ancora altissima, ma non tarderà ad arrivare una release che sistemerà anche questo aspetto, come gli stessi tecnici ammettono.

[ Fra - risorse Cartoon Brew/Adobe ]

Ma allora cos'è andato in onda e come hanno fattoi suoi autori a realizzarlo? Per rispondere alla prima domanda trovate di seguito il video che mostra Homer Simpson (con la voce originale del suo doppiatore Dan Castellaneta) rispondere in tempo reale ad alcuni fans che si sono prenotati al telefono da un lato all'altro degli States, mentre subito dopo invece cerchiamo di far luce sulla seconda domanda.

Il lavoro.

Già diverse settimane prima della messa in onda di questo episodio, subito dopo l'annuncio di questo evento, molti avevano ipotizzato a sistemi di motion capture o marionette o qualunque altro sistema, senza sapere che dietro tutto si nascondeva invece un nuovo software messo appunto dagli ingegneri Adobe.

Tutt'ora in sviluppo, si chiama Adobe Character Animator e ha due particolarità su tutte: la sincronizzazione labiale e la cattura dei movimenti, entrambi in tempo reale.

Grazie ad uno dei registi della serie I Simpson David Silverman e del co-fondatore di After Effect oggi al lavoro su Character Animator David Simon, facciamo luce sul programma e su tutto il processo.

Il regista Silverman (in foto quì sopra) racconta che l'idea di "animazioni in tempo reale" era già nell'aria da qualche anno. Poi il team de I Simpson ha notato il lavoro della divisione grafica del canale Fox Sports sulla mascotte robot Cleatus che interviene in tempo reale durante gli incontri. Da quì si è arrivati ad una nuova feature di After Effect, una versione preliminare di Character Animator, programma in grado di gestire e animare gli "strati" (layer) 2D di Abobe Illustrator (grafica vettoriale) o Photoshop (grafica raster o bitmap) - quest'ultimo scelto per questo segmento/esperimento de I Simpson.

Per fare un esempio: per far parlare un personaggio 2D è necessario realizzare tanti disegni della bocca quante le esplessioni dei fonemi o principalmente quelle delle vocali (visto che molti fonemi hanno espressioni in comune). Questi disegni sovrapposti uno dietro l'altro, formano parole e intere frasi. La programmazione di questi disegni di solito è fatta secondo i copioni precedentemente scritti e l'intero processo non è certamente da intendersi in tempo reale, anzi, ogni secondo di animazione prevede fino a 24 immagini differenti con conseguenti tempi di produzione molto lunghi.

In questa fase può interviene questo nuovo software.

Si parte impostando per prima la scena completa con lo sfondo e tutti i personaggi e gli elementi in movimento e non, e definendo poi quali elementi devono interagire con il programma d'animazione (esempio: quale disegno corrisponde alla lettea "A", quale alla "E" ect.). All'inizio, nelle prime versione del software, il lavoro era tutto effettuato tramite la pressione dei tasti di una tastiera, sempre in tempo reale, (dunque con una tastiera o un keypad con pre-impostati azioni/movimenti per ogni tasto) ma solo ultimamente si è arrivato al livello successivo, il vero salto di qualità, che comprende la sincronizzazione labiale tramite l'audio di un microfono e le espressioni facciali e i movimenti tramite la cattura del video di una videocamera.

Ricordando che il software è tutt'ora in fase di sviluppo, per l'episodio live de I Simpson non è stata utilizzata la cattura dei movimenti in tempo reale ma solo la sincronizzazione labiale con la voce di Dan Castellaneta e una tastiera (il keypad in foto quì sopra) operata dal regista in persona in cui erano state impostate delle animazioni collaterali (altri prersonaggi non parlanti che entravano in scena) o piccoli movimenti gestuali di Homer, così da poter offrire la stessa qualità dei disegni della serie originale. Molte altre animazioni, ammette il regista, erano state preparate ma non sono poi state usate, pronte solo "in caso di", mentre il risultato finale, continua Silverman, è stato comunque accettabile e ha dato solo qualche piccolissimo problema con le interazioni reali, perchè selezionate tramite tastiera da una persona diversa dal doppiatore che parlava, con al massimo mezzo secondo di ritardo.

Un lavoro di preparazione molto particolare e lungo e una sessione live che il regista stesso ha ammesso di non aver patito grazie alla sua esperienza di musicista, che gli ha insegnato come improvvisare o correggersi in tempo reale sul palco durante un esibizione.

Meglio di tante parole, vi mostriamo di seguito in pochi minuti il potenziale di questo programma:

Il futuro.

Di software in grado di gestire animazioni in tempo reale, principalmente in computer grafica, applicati spesso ai giochi, ce ne sono già sul mercato e Charater Animator non farà altro che apportare nuova carne al fuoco nel mercato delle produzioni animate anche di alto livello, permettendo di abbassare drasticamente i budget, offrire nuovi strumenti per realizzare espressioni facciali e movimenti sempre più precise e lasciare magari concentrare gli autori su altri aspetti importanti della produzione.

Certamente come quest'esperimento con il segmento live de I Simpson conferma, la qualità della sincronizzazione non è ancora altissima, ma non tarderà ad arrivare una release che sistemerà anche questo aspetto, come gli stessi tecnici ammettono.

[ Fra - risorse Cartoon Brew/Adobe ]

Animation Italy

Animation Italy